Space Oddity com o Comandante Chris Hadfield

Apenas tentem assistir a esse vídeo sem se emocionar.

Cotas para universidades públicas federais e ensino médio brasileiro

Eu queria chamar atenção para diversas coisas que tem acontecido recentemente:

- PLC 180/2008 (Senado) e PL 73/1999 (Câmara)

- Resultados do Ideb 2011 (INEP/MEC)

- Desempenho de cotistas fica acima da média (Estadão)

- MEC quer aulas de reforço para cotistas em universidades federais (O Globo)

- [link extra, não comentado abaixo, mas relevante: MEC vai propôr a fusão de disciplinas do Ensino Médio (Folha de São Paulo)]

Todos eles são diretamente sobre a atual situação e mudanças no ensino público brasileiro. Eu vou fazer um passeio por cada um deles, na ordem acima, tentando mostrar o absurdo que está sendo desenhado e a falta de esperança que isso me dá no futuro do nosso país.

Os primeiros artigos se referem à aprovação pelo Senado Brasileiro de um Projeto de Lei da Câmara proposto em 1999, de autoria da Sra. Nice Lobão, que reserva 50% das vagas em universidade pública federais para alunos que estudaram o ensino médio integralmente em escola pública.

Eu não sou contra medidas afirmativas. Mas, ensino superior não é escola. Escola é até o ensino médio. Curso superior é para formar profissionais de alto nível e é um investimento que, pelo menos em princípio, é caro demais para ser feito errado. O que se vê no Brasil é uma inversão dessa idéia: muita gente vai para universidade só pelo diploma e a grande maioria das pessoas que se forma terminam trabalhando em empregos que não necessitam a formação que receberam. Além disso, o investimento é muito aquém do que eu considero necessário. Então já estamos começando errado.

Ser educado é uma necessidade do cidadão. Eu realmente acredito que uma pessoa só exerce plenamente sua cidadania se for educado. Por outro lado, ser um físico especialista em AdS/CFT, um engenheiro projetista de pontas em concreto protendido ou um neuro-cirurgião é não necessidade para ninguém exercer cidadania. É, contudo, uma necessidade ao país que haja pessoas especializadas nessas áreas e é bom que essas pessoas sejam boas no que fazem, já que esse tipo de atividade costuma ser de alto nível técnico.

Logo, o dinheiro investido numa universidade deve ser investido naquelas pessoas que mostrem motivação e aptidão para serem treinadas nessas atividades. De outra forma, seria jogar dinheiro e tempo das pessoas fora. Mais do que isso, seria correr o risco de não ter profissionais de alto nível técnico no país – e é isso que acontece. Medidas afirmativas no nível superior não servem para criar justiça social. É loucura fazer isso nesse nível. Medidas afirmativas no nível superior servem para consertar casos isolados de pessoas que são realmente muito boas e que de outra forma teriam o talento para essas profissões altamente especializadas desperdiçado.

O que eu quero dizer é que medidas afirmativas no ensino superior não é para servir à pessoa, mas para servir à sociedade. E, me desculpa, precisa ser muito ingênuo ou mal intencionado para achar que colocar 50% das vagas em medidas afirmativas vai ajudar a sociedade de qualquer forma. E eu vou defender o porquê estou falando isso.

Vamos olhar então o segundo link. Ele tem os dados do Ideb, que é uma avaliação do ensino básico (fundamental e médio) brasileiros que é feito desde 1997. A avaliação leva em conta duas coisas: o resultado de provas padrões aplicadas aos alunos no final do 5o ano (antiga 4a série), 9o ano (antiga 8a série) e 3o ano do ensino médio e o nível de abandono e reprovação nas escolas. A página é bem detalhada e você pode gastar bastante tempo olhando os resultados por estado, por município e até por escola! Os resultados também são separados por escolas públicas e particulares, o que serve bem o meu propósito aqui.

A nota é definida da seguinte forma: o resultado da prova padrão é normalizado entre onde

e

são a média e o desvio padrão das notas dos alunos em 1997. Além disso, cada período escolar avaliado recebe um peso dado por

onde

é a taxa de aprovação e a soma k é sobre as séries avaliadas em cada colégio, algo que avalia o tempo médio para um aluno passar de série. O método é interessante mas não permite uma avaliação absoluta do ensino brasileiro, apenas relativa aos anos anteriores. O INEP diz que uma nota 6 seria equivalente à educação em países desenvolvidos, mas eu não faço idéia do que isso significa.

Bem, duas coisas são óbvias dos resultados. Primeiro, desde o início dessa avaliação, os resultados estão estagnados. E aqui eu acho que a desculpa de que educação é um investimento a longo prazo não se aplica mais – 14 anos já é muito tempo! Segundo, o nível das escolas públicas continua sendo por volta de 1.5 pontos abaixo da média, enquanto das escolas particulares em torno de 1 acima. O que é mais triste é que estamos, usando essa estatística descrita acima, 1.3 pontos abaixo do que estávamos em 1997! Ou seja, não só a comparação entre escolas públicas e particulares não mudou, mas na média a educação brasileira piorou.

Dados são sempre muito bem vindos, mas eu realmente não precisava dessa página para saber que o ensino médio público brasileiro é muito ruim. Ou seja, quando você coloca 50% das vagas nas universidades reservadas para essas pessoas, o que você está fazendo é diminuindo o nível das pessoas que entram. É muita vaga, não tem como qualquer pessoa argumentar que as universidades estariam pegando apenas a cauda da distribuição. Mas isso não impede as pessoas de tentarem fazer essa argumentação falaciosa, claro. E isso nos leva ao terceiro artigo.

O jornal O Globo mostra o resultado de políticas de cotas similares que já foram aplicadas em algumas universidades brasileiras e eles tentam argumentar que a nota e nível de desistência dos alunos cotistas é melhor que dos não-cotistas. O argumento é falacioso por várias razões, vamos listar alguns deles:

- No vestibular, poucos cursos são muito concorridos. A maioria é pouco concorrido e a qualidade média dos alunos que entram já é, mesmo sem medidas afirmativas, muito baixa. Nesses cursos, não faz diferença o tipo de cota proposta para a qualidade dos alunos. Contudo, é injusto tirar a média de cursos muito concorridos, onde a qualidade é boa, com esses cursos. Tudo que você faz é apagar a evidência dos casos problemáticos na média.

- Desistência de universidade não mede quase nada. O tempo de jubilamento, mesmo por reprovação, costuma ser gigantesco. Não há pressão para desistência de ninguém na universidade. Além disso muitos cotistas recebem auxílio financeiro, o que desfavorece qualquer intenção de desistência.

- Também posso dizer por experiência de ter vivido numa dessas universidades que adotaram bem cedo um sistema exagerado de cotas que vários cursos tiveram que criar matérias introdutórias para suprir as deficiências dos alunos. Com esse tipo de supletivo fora do lugar é que realmente não há razão para que as notas sejam menores. Não é, pois, em desempenho durante o curso que vai se ver a besteira que está a ser feita. Mas sim na qualidade do profissional que se forma porque, se tempo é usado para revisar matéria do ensino médio, então o conteúdo profissional vai ser prejudicado, seja espremendo-o em cursos mal dados ou mesmo suprimindo-o.

- E, por fim, convenhamos, vários cursos de início de faculdade não exigem um conhecimento direto do ensino médio. O problema, de novo, não pode ser visto na média pois só surgem naqueles outros que exigem. O artigo mesmo diz que a maior discrepância entre cotistas e não-cotistas aparece nas matérias de matemática e não é difícil entender porque. Novamente, tudo que está sendo feito é esconder o problema em grandes médias.

Mesmo se você ignorar todos os pontos acima, só quem nunca entrou numa sala de aula diria que a diferença observada é significativa. A diferença é muito menor que a variância das notas em qualquer um dos grupos de alunos e eu nem preciso olhar para os dados para ter certeza disso.

O penúltimo ponto acima é, de longe, o mais preocupante. Se as universidades realmente forçassem os alunos com deficiência a se nivelarem sem gastar o tempo que deveria ser dedicado a aprender o conteúdo de ensino superior ou a abandonarem, eu não estaria tão preocupado. Mas não é isso que vai ser feito, como pode ser visto na declaração do MEC reportado pelo último link acima. O MEC declara, com todas as letras, que vai querer que as universidades dêem cursos de ensino médio para suprir as falhas de formação dessas pessoas que entrarão na universidade sem condições.

Eu fico chateado com essas cadeia de eventos que vejo sendo formada na minha frente. Fico desgostoso e pessimista com o futuro da educação brasileira. Eu nunca achei que educação privada faça qualquer sentido. Para mim, educação deveria ser exclusivamente pública pois, como defendi acima, é algo que todo cidadão deve ter para exercer seu papel na sociedade plenamente. Contudo, dada a situação do Brasil, é triste o caso em que a única opção de um aluno seja estudar em escola pública e mais triste ainda quando a única opção de um profissional da licenciatura seja dar aula nesses colégios.

Um país onde os professores de ensino médio público ganham, em fim de carreira, R$2,800.00 (veja aqui) enquanto juízes ganham de R$40,000.00 a R$150,000.00 (veja aqui) está errado em suas bases.

Tem mais é que parar de trabalhar mesmo…

E agora José? Esse Higgs é mesmo o Higgs ou não?

Antes de mais nada, deixa eu fazer propaganda de duas coisas bacanas que vi na internet recentemente.

Primeiro, um podcast do Caio Gomes e do Rafael Calsaverini sobre a importância da descoberta do bóson Higgs. Tarefa super ingrata, pois o podcast tinha que ser completamente não-técnico (diferente do que eu escrevo aqui, onde me dou certas liberdades técnicas). Mas eles fizeram um bom trabalho – o papo sobre o Higgs começa em torno de 30 minutos, antes disso é só piada.

Tem vários pequenos deslizes que eu posso comentar com o tempo. Mas tem um deslize muito grande, que eu gostaria de comentar aqui. O Tevatron não foi construído para descobrir o bóson de Higgs e é injusto dizer que ele foi uma falha. O primeiro objetivo do Tevatron foi descobrir o quark top e ele o fez. Esse foi o Run I do Tevatron que aconteceu entre 1992 e 1996. A luminosidade integrada entregue a D0 e CDF foi em torno de o que, como todos sabem, foi suficiente para em 1995 ambas colaborações anunciarem a descoberta desse quark. Os detectores eram bem diferentes naquela época. Por exemplo, o D0 não tinha um solenoide!

Entre 1996 e 2001, ambos os detectores foram modificados para o Run II, que aconteceu entre 2001 e 2011. O D0 recebeu dois novos detectores de tracking (um baseado em fibras cintilantes e um de silício), um preshower (que nunca funcionou muito bem), um solenoide supercondutor de 2T com capacidade de mudar a polaridade e um detector de múons na região frontal. O CDF completou o seu sistema de muons na região central, mudou toda sua câmara de fios (para diminuir o tempo de drifting), construiu o maior detector de silício que existia até antes do LHC (e que deu grandes emoções para eles, um dia eu conto a história), e um novo sistema de calorimetria frontal. Detectores completamente diferentes com propósitos diferentes e um acelerador diferente também: o tempo entre colisões caiu de alguns microsegundos para 132 ns e a energia subiu para quase 2 TeV.

O objetivo das grandes modificações no sistema de tracking (que eram para ser ainda maior, mas não teve dinheiro para tudo) era estudar física de quark bottom. E, novamente, isso foi um sucesso! O CDF foi os primeiro a observar a oscilação do , antes inclusive que experimentos dedicado a física do quark bottom. Muitas medidas do D0 e CDF só estão sendo ultrapassadas agora pelo LHCb.

Os sistemas de identificação de quarks bottom, juntamente com novos cálculos teóricos da seção de choque do Higgs, permitiu que se criasse todo um programa de procura pelo Higgs, principalmente em produção associada WH/ZH decaindo para quarks bottom. E esse programa, apesar das limitações impostas inicialmente nos detectores, também foi de grande sucesso. Usando o canal de WW, foram os primeiros experimentos onde se conseguiu excluir regiões de massa acima do limite do LEP e hoje tem um paper na PRL com uma evidência de justamente nos canais que foram planejados para ter tal evidência. Isso não é um sucesso?

O Run II ainda tinha por objetivo fazer medidas de precisão e a medida da massa do W e da massa do top ainda são mais precisa que as do LHC, mesmo este tendo agora muito mais eventos que o Tevatron. A calibração da escala de energia de jatos para medida da massa do top e da resposta a léptons para medida da massa do W feita no D0 e CDF é ainda a mais precisa já feita na história, mesmo com detectores muito piores que os do LHC (e velhos by now). Eu diria que isso é um grande sucesso.

Então, antes de falar que o Tevatron foi um fracasso, acho que devíamos dar uma olhada em tudo que ele produziu. E isso porque eu não quero nem começar em falar de métodos experimentais. Quem popularizou os MVAs que são usados amplamente no LHC foi D0 e CDF, várias das primeiras análises usando método de elemento de matriz também foram no D0 e no CDF, etc etc etc…

Pronto, ranting mode over.

A segunda propaganda que eu queria fazer é sobre uma série de posts no blog Quantum Diaries. Tem uma editor lá chamado Denis Damazio, quem eu não conheço, que escreve seus posts em inglês e português. E ele obviamente trabalha com o calorímetro do Atlas, que é um sistema de calorimetria muito interessante. Fortemente baseado no calorímetro do D0, mas com modificações para lidar com o intervalo de 25 ns entre colisões que eles planejam ter no LHC (por causa do acidente, eles ainda estão funcionando com 50 ns). Bem, eu não vou gastar mais tempo descrevendo o calorímetro deles, já que o Denis o fez tão bem:

Como um calorímetro funciona, parte 1

Como um calorímetro funciona, parte 2

Como um calorímetro funciona, parte 3

Calorimetria é um assunto que eu gosto muito até porque eu passei meu doutorado inteiro trabalhando com o calorímetro do D0, tanto em hardware, quanto em software online e offline, quanto em análise. Para quem quiser se aprofundar mesmo em calorimetria, essa é a referência canônica:

Calorimetry: Energy Measurement in Particle Physics

Agora que as propagandas e reclamações passaram, vamos falar um pouco de física. No meu último post eu aludi ao fato que, embora seja claro que algo novo foi descoberto, a maioria das pessoas ainda são cautelosas ao associar essa coisa nova ao bóson de Higgs. Note que existe evidências fortes para que esse seja o bóson de Higgs, mas é importante medir todas as suas propriedades antes de dar o carimbo final.

Quais são as propriedades que as pessoas mais querem medir?

Spin: O spin do Higgs no modelo padrão é 0, isto é, ele é um escalar. Na verdade, o primeiro escalar fundamental que, talvez, tenhamos observado. Contudo, nenhuma medida feita até agora permite, de verdade, separar a hipótese de spin 0 da hipótese de spin 2 (a hipótese de spin 1 é descartada pelo teorema de Landau-Yang).

Quando a gente fala em medir spin, a primeira coisa que se pensa é em fazer uma análise angular dos produtos de decaimento. Isso porque, no referencial de centro de massa, a distribuição angular dos produtos do decaimento é dada pela matriz de Wigner para um dado spin e para uma dada helicidade dos produtos.

Idealmente, isso é estudado no decaimento para 2 corpos quando então as helicidades são sempre relacionadas por . No caso do Higgs, contudo, o principal canal de análise seria o decaimento para 4 léptons, já que a direção dos léptons podem ser medidas com precisão muito boa no sistema de tracking. Esse decaimento é um decaimento em cascata através de dois Z e a coisa fica um pouco mais complicada. O seguinte paper faz a análise de como seria essa medida:

Spin determination of single-produced resonances at hadron colliders

Como eu discuti no meu último post, nem sempre podemos realmente chamar o Higgs ou o Z de partículas. Às vezes essa aproximação é boa, às vezes não. Nesse paper eles estudam o caso em que os dois Z são considerados na camada de massa, isso é, como se eles fossem realmente partículas. Esse não é o caso para um Higgs leve, onde um dos Z é sempre muito longe da camada de massa e não obedece a relação . Na verdade, outros papers, sugerem inclusive usar a distribuição de

medida como uma forma de medir o spin do Higgs:

Identifying the Higgs Spin and Parity in Decays to Z Pairs

Veja na figura abaixo que eu copiei do artigo como as distribuições são diferentes para cada spin:

Tem ainda outras propostas mais inusitadas. O artigo

Determination of Spin and CP of the Higgs Boson from WBF

propõe usar a correlação do ângulo azimutal entre dois jatos que às vezes são produzidos junto ao Higgs. Esse modo de produção é chamado de VBF (Vector Boson Fusion). É exatamente o processo inverso ao decaimento para dois Z ou dois W: nesse caso são dois Z ou dois W colidem para produzir o Higgs. Só que então esses bósons vetoriais tem que ser produzidos pelos quarks dentro do próton e, dado que carga de cor se conserva, algo tem que carregar essa carga para o estado final. O que carrega a carga de cor são justamente os dois jatos que o artigo se propõe a usar.

Paridade: O mundo olhado através do espelho não é igual ao nosso mundo. Por exemplo, o que é direito vira esquerdo. Com partículas também acontece isso. Em geral, partículas de spin J, ganham um sinal quando aplica-se o operador de paridade. Essas são as partículas cuja estrutura de Lorentz são descritas por tensores. Mas algumas partículas são descritas por densidades tensoriais, que recebem um sinal extra na transformação de paridade. Em física de partículas, as pessoas chamam isso de paridade intrínsica. E, no Modelo Padrão, a paridade do Higgs é +1.

Bem, num decaimento que preserva paridade é fácil determinar qual é o caso do Higgs. Todos os artigos citados acima sugerem usar distribuições do ângulo azimutal dos léptons no decaimento do Higgs para medir essa propriedade e desconfio que seja assim que a paridade intrínsica do Higgs vá ser medida. Da mesma forma que desconfio que é a através da distribuição de massa que vão medir o spin. Contudo, nenhum desses dois métodos usa toda a informação disponível nos eventos. Para isso, a análise tem que ser feita evento a evento, usando o método de elemento de matriz e eu gostaria muito de ver essa análise feita (na verdade, eu gostaria muito de fazer, mas eu tenho certeza que já tem muita gente fazendo e não é tão fácil assim de qualquer jeito).

Fração de decaimento: Essa talvez seja a propriedade mais simples de se medir e a que deve ter atualizações mais rápidas. A idéia é medir com que probabilidade o Higgs decai para cada um dos estados finais possíveis e ver se o número bate com o Modelo Padrão. Até agora, as únicas frações de decaimento medidas no LHC foram para WW, ZZ e dois fótons. As medidas para férmions ainda não foram possíveis, apesar de terem sido tentadas pelo CMS. A única medida com relativa sensibilidade feita para férmions foi justamente a feita no D0 e CDF recentemente.

Mas isso vai ser feito, inclusive em canais que, apesar de serem de grande resolução, nunca foram usados, como o (veja, por exemplo, Looking for a light Higgs boson in the overlooked channel). Essas medidas são uma forma de confirmar que o acoplamento do Higgs com outras partículas é mesmo proporcional à massa, como deve ser no mecanismo de quebra espontânea de simetria.

Auto-interação do Higgs: O Higgs não só interage com todos os outros campos, como interage com si mesmo. E faz isso mesmo classicamente, no sentido que na ação no modelo padrão tem um termo de interação quártica para o campo do Higgs. Essa auto-interação também é imprescindível para o mecanismo de quebra de simetria eletrofraca, já que é ela que determina que o valor do campo do Higgs não é nulo no vácuo.

Agora, medir isso no LHC é muito difícil. Eu não costumo duvidar da ingenuidade dos físicos experimentais – no passado tivemos exemplos de coisas que nunca poderiam ser feitas mas foram mesmo assim. Mas a maioria das pessoas acredita que mesmo com a 14 TeV, a possibilidade de fazer essa medida não é certa. Para essa medida, o ideal é usar um colisor mais limpo, como os propostos ILC e CLiC que colidem elétrons e pósitrons, em vez de prótons. A idéia seria medir decaimentos do tipo

, que são muito raros e difíceis de identificar.

Novas idéias tem surgido. Uma seria fazer um LEP3 (veja LEP3: A High Luminosity e+e- Collider to study the Higgs Boson) no tunel do LHC. Ele usaria o CMS e Atlas e economizaria muito dinheiro. Outra idéia também interessante é criar um colisor de fótons para estudar o Higgs (veja aqui: SAPPHiRE: a Small Gamma-Gamma Higgs Factory), usando o processo inverso de decaimento para dois fótons. Nesse caso, ainda é necessário construir um acelerador de elétrons, mas em vez de deixar eles coliderem, se joga um laser no feixe e se usa o espalhamento Compton com grandes ângulos para gerar fótons de alta energia e fazê-los interagir.

O futuro da física de Higgs é muito rico e há uma possibilidade grande de se aprender mais sobre a física de altas energias medindo com precisão as quatro coisas descritas acima.

A descoberta do Higgs.

Anteontem finalmente se tornaram públicos os artigos científicos da descoberta do bóson Higgs anunciada dia 4 de julho, no CERN (o link tem inclusive o vídeo desse anúncio histórico). Ei-los:

Observation of a new boson at a mass of 125 GeV with the CMS experiment at the LHC

Ambos foram enviados para publicação na Physics Letters B e devem aparecer em breve. Meu objetivo aqui, contudo, não é apenas fazer esse anúncio, mas tentar explicar alguns conceitos que acho que pessoal não explica muito bem. A maioria deles eu já expliquei aqui no blog no passado, mas nunca faz mal falar de novo.

Que história é essa de o Higgs dar massa para as partículas?

O Higgs não dá massa para partículas, mas sim torna possível que elas tenham essa massa. O importante é entender porque então eles não deveriam ter massa em primeiro lugar.

Em teoria quântica de campos, a não ser que você tenha uma boa razão, todos os campos deveriam ser massivos e com massa na ordem de grandeza da validade da teoria. Contudo, o Modelo Padrão tem como princípio organizador o fato que as interações são descritas por teorias de gauge. E, em teorias de gauge pura, os bósons vetoriais fundamentais de gauge não tem massa. Logo, existe uma boa razão para os campos vetoriais não terem massa mas alguns deles tem, como o W e o Z. A diferença entre um bóson vetorial com massa para um sem massa é a componente longitudinal de polarização, que só existe no caso massivo.

Férmions espinoriais de Dirac (quarks e leptons) são campos diferentes porque são na verdade dois, o campo quiral e o anti-quiral. No Modelo Padrão, essas componentes tem carga (não elétrica, mas da força nuclear fraca) diferente e não podem ser misturadas. Se esse tipo de campo tivesse massa, essas duas componentes se misturariam. Logo também existe uma boa razão para os férmions espinoriais de Dirac não terem massa.

O Higgs resolve esses dois problemas. O campo de Higgs tem 4 componentes. 3 delas funcionam como componente longitudinal de polarização para o W+, W- e para o Z. A quarta componente gera justamente a partícula que foi encontrada. Além disso, na presença do campo de Higgs, o vácuo tem carga fraca não nula. Assim, o vácuo pode suprir a diferença de carga entre as componentes quirais e anti-quirais dos férmions espinoriais de Dirac.

A única partícula para qual não existe uma boa razão para ter massa zero, ou pelo menos muito baixa, é o próprio bóson de Higgs. O Higgs é um escalar e logo não possui componentes quirais, nem graus de liberdade de polarização. Logo, o Higgs deveria ter uma massa muito grande, na escala de validade do Modelo Padrão e, comparado a essa escala, o Higgs é bem leve. Esse é chamado de problema da hierarquia e nenhuma solução proposta (supersimetria sendo a mais famosa) parece ser a escolhida pela natureza.

O Higgs foi mesmo produzido? Existe mesmo uma partícula de Higgs?

Mais ou menos e vamos entender porque mais ou menos. Existir, ela existe, mas não no mesmo sentido que um elétron existe. Essa seção pode ficar técnica muito rápida, então vou usar umas analogias que, embora corretas, são um pouco forçadas. Em teorias quânticas, devido ao princípio de incerteza de Heisenberg, interações que acontecem muito rápido não precisam respeitar exatamente a equação de Einstein porque intrinsicamente impossível saber a energia com precisão.

Apenas quando se observa uma partícula por muito tempo é que, assintoticamente, essa relação vai ser obedecida. Bem, no caso de partículas instáveis, como o Higgs, isso não acontece porque ele decai rapidamente e o próprio conceito de ser assintótico não é bem definido. O tempo de decaimento do Higgs é em torno de que é muito curto nas escalas humanas.

Claro que usar escalas humanas não é o adequado para dizer se algo é rápido ou não. O que se usa em física é converter esse tempo para uma energia () e converter a massa para uma energia (

) e daí usar a massa da partícula como escala. E, usando essas conversões, o tempo de decaimento é 5 ordens de grandeza maior que a massa! Ou seja, o conceito de partícula de Higgs é razoável em várias situações e é por isso que você ouve frases como “a probabilidade de se gerar uma partícula de Higgs no LHC é…”.

Na realidade, o Higgs aparece mesmo é como uma ressonância: como um aumento na seção de choque da produção de outras partículas. E é isso que se faz no LHC, se estuda a interação entre glúons dentro do próton quando um certo estado final de partículas é produzido. Alguns desses estados finais são modificados pelo Higgs. Apesar de ser um fenômeno de ressonância, a contribuição do Higgs para esses processos ainda é muito menor que a contribuição de outros campos e é por isso que fica tão difícil estudar as propriedades do bóson de Higgs.

Grande parte do design no LHC foi motivado por isso. Por exemplo, a idéia de se ter uma energia muito alta é estar mais perto da ressonância. A idéia de se ter uma intensidade do feixe muito grande é poder distinguir com certeza contribuições muito pequenas à seção de choque. As interações mais interessantes de se estudar são aquelas em que todo o estado final pode ser medido e em que a contribuição de outros campos não é tão grande assim. Dois estados finais são realmente relevantes então: a produção de dois fótons e de quatro léptons (elétrons ou múons)

. Nesse sentido, tanto ATLAS quando CMS tem como maior especialidade a identificação e medida do momento de fótons, elétrons e múons de altas energias.

Foi mais fácil ou mais difícil do que inicialmente imaginado?

Bem, com certeza demorou mais do que eu esperava. A principal razão foi o acidente em 2008 que atrasou o início das operações do LHC e que limitou a energia dos prótons a metade do que se esperava inicialmente. Para compensar, o pessoal do LHC começou a colidir vários prótons de uma vez só, porque assim, na prática, a probabilidade de acontecer a produção de um desses dois estados descritos acima é maior.

O que acontece é que cada vez que esses estados finais são produzidos, outras muitas coisas também são e em lugares diferentes em torno do centro do detector. Daí, várias questões experimentais começam a surgir. Por exemplo, vamos dizer que você observou um fóton e mediu a energia dele. Para medir o momento você ainda precisa da direção, mas fóton não deixa traço no detector porque não é eletricamente carregado. Como saber de qual das interações ele veio?

Outro problema é na própria identificação dessas partículas. Por exemplo, um elétron ou fóton no calorímetro é muitas vezes identificado pelo formato do chuveiro. Mas esse formato é duramente alterado pela presença das partículas vindas das outras interações. Múons são bem resilientes a esse problema e, em vários aspectos, fornecem as medidas mais precisas. Por outro lado, neutrinos são muito sucetíveis a esse problema, pois são medidos por conservação de momento na interação. Com mais interações, a capacidade de se fazer essa medida piora e é por isso que estados finais com neutrinos são usados apenas marginalmente.

E como é feita essa procura? E como se sabe que foi uma descoberta?

Como é feito a procura depende muito do tipo de estado final que se está observando e cada colaboração ainda faz escolhas bem diferentes para um mesmo canal. Talvez uma das análise mais simples seja o do ATLAS. Essa é a distribuição de massa invariante do sistema de dois fótons (não, a massa invariante de dois fótons não é zero, apesar da massa de cada um individualmente ser… um efeito interessante da relatividade de Einstein):

É óbvio que são produzidos muito mais fótons do que no gráfico (concentre-se no vermelho, por enquanto). Esse gráfico mostra, dentre aqueles fótons que são efetivamente identificados e medidos, os que são seleciados numa região em que a contribuição do Higgs para produção é mais forte. No gráfico é claro que há um aumento da produção, um excesso de eventos, uma ressonância, em torno de . Isso é devido ao Higgs. Mas note como esse aumento, mesmo depois de um exercício de seleção e identificação intenso, é pequeno comparado ao número total de estados finais com dois fótons produzidos.

O que se faz então é estudar com que chance esse pequeno excesso poderia ter sido produzido por uma flutuação estatística na hipótese em que o Higgs não existe. Então, se cria um modelo para a produção de fótons na ausência de Higgs e um na presença. Nesse caso específico, o modelo é completamente ad-hoc. Para a hipótese sem o Higgs, o modelo é um polinômio de quarta ordem e, na hipótese de presença de Higgs, soma-se a isso uma função crystal ball. No canal , os modelos são os previstos por teoria quântica de campos incluindo os efeitos do detector.

Uma função de verosimilhança é calculada entre esses modelos e o sinal, considerando que a distribuição de cada ponto no histograma é Poisson. Incertezas sistemáticas são introduzidas por uma técnica semi-bayesiana chamada profile likelihood. É semi-bayesiano porque, tal como numa aboradagem bayesiana, as incertezas sistemáticas são introduzidas através de priors. Esses priors são quase sempre distribuições simples (normais, log-normais,…) que refletem essencialmente a incerteza com que a origem da flutuação sistemática foi determinada. Contudo não é completamente bayesiano porque esses priors não são marginalizados. O que se faz é maximizar a função de verosimilhança, originalmente em função da massa do Higgs e da seção de choque de produção, também em função dos parâmetros de nuisance. No fim, é como se esses parâmetros fossem determinados como função da massa do Higgs e não como se a massa do Higgs fosse determinada como uma média ponderada sobre esses parâmetros, que é a abordagem bayesiana.

Depois dessas contas você tem um valor para o profiled likelihood nas duas hipóteses. Devido ao lema de Neyman-Pearson, a melhor estatística de teste para separar as duas hipóteses é a razão entre os likelihoods da hipótese alternativa e da hipótese nula. Essa razão segue uma distribuição de probabilidade que é diferente no caso o Higgs existir e no caso dele não existir. O que se está interessado é a probabilidade de se observar uma razão de verosimilhanças, na hipótese do Higgs não existir, pelo menos tão extrema (nesse caso, maior que) quanto a que foi observada. Isso, claro, é apenas a integral da distribuição entre o valor observado e infinito.

Essa distribuição, devido a todos os efeitos acima, é meio louca e se costuma traduzir o valor da integral para o valor que deveria ter sido observado no caso em que distribuição da razão de verosimilhança fosse gaussiana com média zero e desvio padrão unitário para que a integral tenha o mesmo valor. E isso é o que é a quantidade de “sigmas” de evidência que todo mundo fala. Resumindo a história, esses sigmas querem dizer o seguinte: suponha que eu faça um número muito grande de experimentos e que eu calcule essa mesma razão de verosimilhança neles, em qual fração deles eu vou observar uma razão pelo menos tão diferente do que eu observei, conforme o que é esperado no caso do Higgs não existir. Ou seja, dito de outra forma, qual é a probabilidade de, assumindo que a hipótese nula é verdade, de eu estar errado em negá-la (normalmente chamado de erro tipo I).

Esse número é bem pequeno! No caso do canal , a evidência no ATLAS é de

e juntando todos os canais a evidência é de

(algo como uma vez em um bilhão). O CMS teve resultados similares e por isso que ambos se sentiram confortáveis em dizer que uma partícula foi descoberta, que é o bóson de Higgs.

Mas essa partícula parece mesmo com o bóson de Higgs do Modelo Padrão?

Bem, muito pouca coisa foi medida sobre ela até agora. Mediu-se a massa, a seção de choque total, e algumas seções de choque parciais. E, tudo isso que foi medido é perfeitamente consistente com o Higgs do Modelo Padrão. Mas também é consistente com outros modelos, por exemplo, com o Higgs na supersimetria. Nesses tipos de modelo, sempre tem um campo que é muito parecido com o Higgs do Modelo Padrão e por isso que ainda é muito cedo para distinguir entre eles (embora já haja artigos na praça tentando fazer isso). A figura abaixo mostra a consistência medida no ATLAS entre cada canal de decaimento e o Modelo Padrão (a linha pontilhada em 1):

Em termos de consistência entre ATLAS e CMS, tudo também parece ok. ATLAS mede uma massa de . O CMS mede

. Claro que uma verificação exata da consistência precisaria levar em conta correlações, mas de olho a diferença é na ordem de

, o que é algo que qualquer pessoa chamaria de consistente. Impressionante que, e aqui eu vou ignorar correlações de novo, a primeira medida da massa de uma nova partícula já foi feita com uma precisão relativa de 0.3%! ATLAS e CMS são, de fato, detectores fantásticos.

Notícias da Semana…

Nos últimos 7–10 dias, muitas notícias interessantíssimas apareceram. E vale a pena dar uma olhada no que está circulando pelo mundo afora.

- “Brazil a Great Place to do Physics … and Other Things“: Esse primeiro link é sobre programa de intercâmbio da APS, e o caso da reportagem conta sobre um aluno que saiu da Columbia University, em NY, e foi para o CBPF, no RJ. Como diz o rapaz que fez o intercâmbio, “Given that Rio was one of Richard Feynman’s favorite places, I was sure the experience would be very interesting, and I quickly became excited about it.”. 🙂

- “Brown University forges research partnership in Brazil“: Esse segundo link é sobre a parceria que a Brown University assinou nessa semana com o IMPA (RJ). A parceria, promovida pela doação de um pai dum aluno da Brown, vai promover a colaboração em pesquisas, conferências e intercâmbios entre a Brown e o IMPA pelos próximos três anos.

- “Open grad program allows students to pursue two fields“: Esse terceiro link é sobra um programa piloto que a Brown abriu esse ano e que poderia ser resumido como “Ciências Moleculares para a pós-graduação”. A Brown tem um currículo de graduação aberto, como o do Ciências Moleculares, desde os anos 70. E, agora, eles decidiram aplicar o mesmo princípio para a pós-graduação. A idéia é de que os alunos selecionados para participar desse experimento irão cursar seus respectivos doutoramentos, que será complementado com um mestrado em alguma outra disciplina. (A Brown permitia que seus alunos tirassem um ‘double-masters’, i.e., um duplo-mestrado até alguns anos atrás, quando essa opção foi cancelada em favor dessa nova empreitada multi- e inter-disciplinar.) E é disso que trata a reportagem, desse experimento em se ter um currículo multi- e inter-disciplinar na pós-graduação. Até onde eu conheço, essa é uma atitude completamente pioneira e que não existe em nenhuma outra escola. 😈

- “How the Modern Physics was invented in the 17th century, part 1: The Needham Question“: Essa é a primeira parte (de um total de 3) de um blog convidado da SciAm, contando a história da Física moderna. Muito interessante.

- “How Much Is a Professor Worth?“: Essa matéria do NYT trata do tópico de um novo livro que tenta comparar o salário de professores em diferentes países. Vale a pena ler pra ver em qual posição o Brasil se encontra, e como os diferentes países se comparam. Há muitos detalhes a serem analisados nessa questão todo… mas, de qualquer maneira, é um bom começo.

- “Sociedade Brasileira de Física — Cortes no orçamento de ciência ameaçam futuro do Brasil“: o governo decidiu cortar o orçamento em cerca de 33% (comparado ao orçamento de 2010), entrando em rota de colisão com diversas conquistas recentes da política científica federal.

- “Carnaval Is Over“: Seria esse o fim do milagre brasileiro? A FP faz uma lista dos vários fatores que influenciam essa questão.

Parcerias científicas internacionais, flexibilização do currículo da pós-graduação, história da Física, cortes do orçamento de ciência e tecnologia, e futuro econômico do país. Todas notícias relevantes e contemporâneas.

“E agora, José?”

ILC e LBNE em perigo

Vi no blog do Lubos Motl links para as seguintes reportagens:

Fermilab loses federal funds for experiments

O ILC é um projeto de um acelerador linear de elétrons que permitiria medir propriedades de partículas pesadas, em particular o quark top, o bóson de Higgs e o bóson W com altíssima precisão. Isso é importante pois apesar de ser claro que o LHC vai fazer várias medidas do Higgs, o estado inicial hadrônico junto com o grande pile up fazem com que medidas de precisão dos acoplamentos do Higgs sejam muito difíceis de serem feitos. O ILC também contemplava a possibilidade de sintonizar em novas ressonâncias que possam ser descobertas, por exemplo algo que faz a comunicação entre o setor supersimétrico e o não-supersimétrico, o que permitiria estudar o espectro da supersimetria também com grande precisão.

O Fermilab teve sua verba para esse projeto completamente zerada. Há interesse de outros países em construir o ILC, como no Japão por exemplo, e há outros projetos de aceleradores lineares, como o CLiC do CERN. Espero que algum se torne realidade.

O LBNE é um experimento com feixes de neutrinos similar aos muitos que já existem, mas com uma distância maior entre o ponto que o feixe de neutrinos é produzido e o detector, que ficaria num laboratório subterrâneo construído numa mina em South Dakota (Homesteak). O laboratório em si, o DUSEL, já sofreu cortes imensos e agora foi a vez do projeto no Fermilab sofrer cortes e o diretor do laboratório disse que eles iriam reavaliar o projeto. O futuro é bem incerto, mas uma versão reduzida deve ser feita, já que ele é de extrema importância para o futuro do Fermilab.

O objetivo desse experimento seria medir os ângulos de mistura de neutrino com grande precisão e a fase de violação de CP nesse setor. A recente descoberta de que o ângulo de mistura é grande inclusive aumenta a possibilidade de se medir os efeitos de violação de CP que vem diretamente da mistura de neutrinos. O fato do laboratório ser subterrâneo, também permitira estudar outras fontes de neutrinos: como os produzidos na atmosfera terrestre e em supernovas na nossa galáxia.

Top 10 de Primavera

Me disseram que eu não tenho escrito muito no blog (e, aparemente, nenhum dos meus colegas). Então eu resolvi colocar um título para esse post que sugere que o próximo virá só em 3 meses. Esse post vai ser um apanhado de resultados recentes e interessantes (na minha óptica limitada) em física de partículas. Do jeito que esse campo tem andado rápido, eles já não são nem tão recentes assim, mas tudo bem. Sério, vão ser apenas clippings com curtas explicações do porque eu acho interessante. Tipo um “Top 10”. Preparados? Apertem os cintos…

10. LHC está ligado de novo! Desde semana passada o LHC tem feixes em seus aceleradores. Não há colisão ainda, apenas em abril. Mas as condições do acelerador para esse ano já estão determinadas:

- 8 TeV de energia (4+4)

- 50ns entre cada colisão

- Maior focalização dos feixes no ponto de colisão (

)

- 126 dias de colisão (

)

Claro que os experimentos gostariam que tivesse mais energia e menos tempo entre colisões, mas isso é tudo que a máquina pode fazer até agora. A luminosidade de pico vai ser em torno de , o que é ótimo, mas o pile-up deve ficar na faixa de

colisões simultâneas. Claro que para os golden modes (

) isso não importa muito. Mas para física com MET, isso vai ser um fator limitante (apesar do otimismo dos experimentos).

9. Colisão de íons pesados. STAR, PHENIX, Atlas, CMS e ALICE publicaram mais resultados sobre colisões de íons pesados. Esse é um tipo muito difícil de física, porque é muito difícil extrair informação dos dados coletados. A grande maioria dos trabalhos verifica a evolução termodinâmica do meio formado na colisão (o “plasma de quarks e glúons”). Diversos efeitos que eram considerados interessantes no passado e que receberam nomes chiques como The Ridge e Mach Cone agora são entendidos como frutos de anisotropias superiores. Superior aqui quer dizer além da segunda ordem numa expansão em série de Fourier. A segunda ordem, chamada nesse caso de “fluxo elíptico” (por motivos óbvios), é sempre esperado numa colisão de íons. O fato de harmônicos superiores explicarem efeitos no estado final é meio decepcionante (vocês se lembram a festa que o CMS fez quando observou o ridge pela primeira vez), mas deve ser esperado dada a baixa viscosidade que se sabe que esse meio tem.

Também saíram vários artigos que estudam as partículas que são produzidas dentro desse meio contínuo de quarks e glúons. De novo, esse meio é tão bagunçado que é difícil tirar qualquer conclusão precisa sobre ele. Para mim, o mais interessante é quando é produzido um jato. Ano passado o Atlas mediu pela primeira vez o chamado Jet Quenching e foi algo muito impressionante. Agora, tanto CMS quanto Atlas tem uma multitude de medidas variando rapidez, centralidade, … Do que eu li desses artigos, tudo que se concluí é que nenhum modelo prevê isso decentemente. Mas também, it is a mess!

8. Heavy Flavors. Tem saído uma multitude de trabalho medindo ressônancias desconhecidas com baixa massa. Quando eu comecei a fazer física era apenas uma. Agora, artigos publicados por BESIII, Belle, Babar, LHCb tem achado uma multitude de estados (todos recebem o nome X) que não parece se encaixar em nenhum multipleto. Há um grande e interessante esforço em se medir as propriedades (massa, carga, spin, simetrias discretas) desses novos estados descobertos por esses experimentos, mas a estrutura deles ainda é desconhecida. Seria um acoplamento fraco de dois mésons (tipo uma molécula de méson)? Seria um acoplamento forte de mais de três quarks (tetraquarks)? Ninguém realmente sabe.

Na parte de física de B, o LHCb continua a escrever um livro sobre o assunto. Eles tem publicados uma infinidade de medidas sobre o decaimento de mésons B. Todas em perfeita concordância com o modelo padrão (apesar do que o CDF pode ter dito no passado). Há inclusive alguns cadidatos a ! Eles ainda não põem limites bilaterais na largura de decaimento do

, mas estão muito próximos. Esse tipo de medida é muito importante para se dizer algo sobre extensões do modelo padrão sem ter que considerar modelos específicos. Por exemplo, com o limite que o LHCb põe nessa largura de decaimento, teorias supersimátricas com alto

estão mortas.

Também apareceram alguns artigos teóricos mostrando que a violação de CP direta medida pelo LHCb há algum tempo atrás é sim prevista pelo Modelo Padrão. Parece que o problema na conta era uma expensão não tão bem controlada em e, quando se usa dados medidos para controlar essa conta, a previsão para violação de CP direta em decaimentos de

é da ordem do observado pelo experimento.

7. QCD. Como é esperado, muitos resultados tem aparecido, mas aqui o mais interessante tem sido os resultados teóricos. Vários artigos interessantes foram escritos nesses últimos meses. Tanto o CMS quanto o Atlas mediram uma grande produção de estados finais com dois fótons (em baixa separação angular) ano passado. Alguns apressados chegaram a gritar “nova física”! Mas eu acho que era óbvio que não era. Quando a conta foi feita em NNLO, a previsão da QCD bate direitinho com os dados medidos. Isso é muito importante para procura por Higgs quando esse é feito com alto momento.

Também apereceram contas mais refinadas (em NNLO) da produção de Higgs e de bósons vetoriais massivos (W,Z). Kudos para os grupos italianos (Grazzini e cia) e argentinos (de Florian e cia) que estão cruzando a barreira no NLO e fazendo com que a gente entre na época do NNLO.

Agora, a conta mais impressionante desses últimos tempos é a seção de choque de top-antitop em NNLO (Mitov e cia). Essa é uma conta em NNLO tal como as outras acima, mas com vários jatos no estado final. Isso é muito importante para se calcular precisamente observáveis como a assimetria forward-backward, que até hoje só foi calculada em ordem mais baixa de teoria de perturbação. Muitas coisas não concordam com o primeiro termo de uma expansão pertrubativa, principalmente quando novos canais de produção são abertos a cada nova ordem. E é justamente por isso que as medidas do CDF e D0, apesar de muito interessantes (e experimentalmente complicadas de se fazer quando se separa em massa invariante), têm que ser levadas com pé atrás do lado teórico. Eu sei que tem gente que investe sua carreira em buscar modelos para explicar essa assimetria, mas eu não ficaria surpreso se contas refinadas do modelo padrão explicarem sua origem. Falando nessas medidas, parece que foi entendido qual era o problema com a previsão teórica do momento transverso do par top-antitop na medida da assimetria forward-backward do D0. Aparentemente, quando se considera radiação no estado final corretamente, a medida bate perfeitamente com QCD.

6. Neutrinos. Finalmente mediram o último ângulo de mistura (com os famigerados

“exigidos” na minha área). E não foi um experimento de acelerador.Esse ângulo foi medido usando o desaparecimento de neutrinos de elétron produzidos em usinas nucleares. Claro que pessoal do T2K e do MINOS ficaram chateados, mas por outro lado foi uma boa notícia. Isso porque o ângulo medido pelo Daya Bay (e em perfeito acordo com a evidência observada pelo Double-Chooz anteriormente) é maior do que poderia se imaginar por argumentos de naturalidade.

E o que isso tem de bom? Bem, com um ângulo tão grande, o experimento NOvA, no Fermilab, vai conseguir resolver o problema de hierarquia das massas dos neutrinos e experimentos como o LBNE podem medir o ângulo de violação de CP. Com tudo isso resolvido vai ficar faltando a questão da massa de Majorana dos neutrinos e um arcabouco teórico decente para explicar tudo isso.

5. Top. O quark top é a grande janela para descoberta de nova física no LHC. Who ordered such large mass? é a pergunta que todo mundo se faz. O acoplamento de Yukawa do top é ! Medir a massa e a seção de choque (total e diferencial) do quark top com precisão é, na minha humilde opinião, o que tem alguma chance de mostrar desvios do modelo padrão. Claro que para isso temos que ter cálculos também precisos e grandes passos tem sido dados, como eu discuti acima. Os experimentos não estão ficando atrás. O D0 e CDF continuam melhorando suas medidas da massa do top, com precisão já na casa dos

. O CMS anunciou uma medida na mesma casa de precisão, mas eles receberam críticas duras por não terem levado em consideração incertezas vindas de reconexão de cor, underlying event e hadronização. Essas são as incertezas que limitam esse tipo de medida hoje em dia e não levá-las em consideração é muito feio.

Claro que quando se chega nesse nível de precisão, começa-se a ser importante se definir exatamente em qual esquema de renomalização essa massa está sendo medida. E, surpresa-surpresa, ninguém sabe realmente. Essa massa do top que está se medindo é um parâmetro dentro do Pythia que não tem nenhuma conexão direta com um esquema de renomalização. Claro que se pode medir a massa direto da seção de choque, quando entrão o esquema de renomalização é claro. Mas a precisão é muito pior.

Eu costumo perguntar para as pessoas que trabalham com isso quão perto essa massa é da massa de polo… algumas pessoas me dizem , outras me dizem que pode ser tão grande quanto

(que é a diferença entre a massa de polo e de MSbar. É meio triste que ninguém saiba isso direito, pois a massa do quark top é um ingrediente importante para a consistência do modelo padrão. Se você tem interesse no assunto e sabe TQC, que tal calcular isso?

A família (top, bottom) também é o canal mais importante para procura por supersimetria. Hoje o Atlas publicou um monte de procuras usando todo o dataset do ano passado e os limites de massa de squark-gluino de primeira geração já passou o ! São massas desconfortavelmente altas. Muita gente tem dito que é possível que o único sfermion leve seria o stop, cujos limites são muito mais fracos. Tem gente que vai além, colocando todos os sfermions pesados (tipo a proposta do Arkani-Hamed de split supersymmetry) e esse tipo de modelo fica menos limitado ainda! É claro que esse tipo de modelos estão ganhando notoriedade simplesmente porque não está se achando nada nos mais simples. 😛

4. Matéria escura. Outra bagunça. Tem tanto experimento e tantos resultados que nem sei por onde começar. Tem aquela modulação observada pelo DAMA e pelo CoGeNT, mas o CDMS não observa nada. Claro que não observar nada pode ser interessante, porque os métodos de detecção são diferentes e sensíveis a hipóteses diferentes de matéria escura. O LHC também procura por matéria escura em eventos com apenas 1 jato, mas também não acha nada. E os limites do LHC para massas intermediárias é inclusive melhor que de procuras diretas. Claro que em energias muito altas, procuras diretas é a única coisa que se pode fazer. Bem, o cenário ainda é muito bagunçado para mim e vou parar de falar, mas existe mais de 10 experimentos procurando diretamente por matéria escura e os resultados vão continuar a sair. No futuro eu acho que a situação vai ser mais clara.

3. Diboson. Essa é a minha segunda janela favorita para nova física depois do top (com a vantagem que os estados finais são muito mais limpos). A seção de choque desses bichos é tão sensível à nova física que se o CMS e o Atlas medirem isso com precisão, há uma ótima possibilidade de se ver algo novo. Ambos experimentos tem apresentado medidas cada vez melhores da seção de choque total. É curioso que tanto o Atlas quanto o CMS medem a seção de choque de WW maior que o modelo padrão. Será que tem algo aí? É cedo para dizer, mas eu acho que vale a pena manter o olho aberto.

O CMS também fez a primeira medida de . Um evento raro e bonitinho que o LEP tinha tido uma observação com baixa significância estatística o Tevatron passou longe.

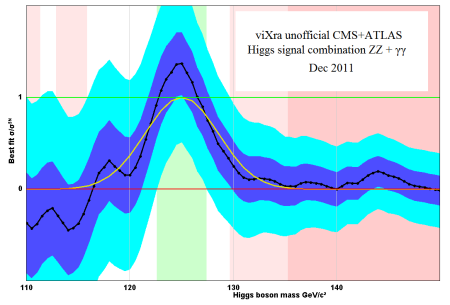

2. Higgs. Mesma coisa de sempre. Até agora, nenhum sinal de combinação entre Atlas e CMS. Mas como eu já disse aqui no blog, apesar de estar curioso, acho que é cientificamente melhor assim. A faixa em que o Higgs ainda pode estar é, agora . Como a resolução dos experimentos é mais ou menos essa aí mesmo, a procura agora é mais por excesso de eventos do que por um pico mesmo. Eu acho que vai ser rápido, mas vamos ver.

Alguns comentátios mais pessoais, que podem ser coisas da minha cabeça, mas vale a pena manter o olho aberto. O CMS refez a análise no canal usando métodos de análise multivariada (MVA). É engraçado ver que eles tem dois excessos com quase a mesma significância, mas um deles numa área já excluída (em torno de 136 GeV). Também é interessante ver que tanto o Atlas quando o CMS tem um déficit bem significativo em baixa massa (em torno de 113 GeV). Eu não sei o que significa essas coisas, talvez não signifique nada, mas é curioso.

Outra coisa curiosa é o déficit que o Atlas observa no canal de WW. Parece mais problema de análise que algo realmente de física, mas só o futuro dirá. Talvez seja apenas um flutuação, é cedo para dizer.

O Tevatron publicou a combinação da procura pelo Higgs do D0 e CDF. Há um discreto excesso na mesma área em que Atlas e CMS observaram, mas a evidência estatística é desprezível. Primeiro porque são pouquíssimos eventos e depois porque o principal canal que dá o excesso é com quarks b, cuja resolução de massa é péssima. Eu acho até meio feio o escarcéu que está sendo feiito com algo tão insignificante, mas tudo bem… é análise é realmente impressionante e o esforço posto nela é imenso. Só não dá para competir com o LHC porque esse foi um experimento feito para isso! Como um colega disse, é o look overseas effect. O CDF tem feito uma propagada imensa do seu novo b-tagger (o HOBIT), que foi otimizado para procura por Higgs. Outra bobagem, o D0 tem algo com eficiência semelhante há algum tempo já (é provável que tenhamos um guest post sobre b-tagging em breve, aguardem!). O que o CDF faz bem (leia-se, muito melhor que o D0) é ter mais análises, com estratégias diferentes. Algumas com S/B bem alto, outras bem baixo. Como as estratégias não são completamente correlacionadas, o CDF ganha em sensitividade.

1. Massa do W. Sim, saiu! Depois de muito esforço, meu artigo saiu (e já está aceito para publicação no PRL)! Tanto o D0 quanto o CDF mediram a massa do W com precisão pelo menos tão boa quanto a média mundial anterior! Realmente impressionante. Esse assunto realmente merece um post só para ele… quem sabe daqui a 3 meses? 😛

Neutrinos, cabos and all that jazz!

Eu realmente não tenho tempo de comentar agora, mas vai uma tradução (Sim, o texto não é meu! Não me processem!) dessa bomba que está se propagando rapidamente:

BREAKING NEWS: Error Undoes Faster-Than-Light Neutrino Results

Parece que os resultados com neutrinos acima da velocidade da luz, anunciados em setembro do ano passado pela colaboração OPERA na Itália, era um erro no final da história. A culpa é de uma conexão ruim entre uma unidade de GPS e um computador.

Físicos detectaram neutrinos viajando do CERN, em Genebra, até o laboratório de Gran Sasso, perto de L’Aquila, que pareciam fazer a travessia aproximadamente em 60 nanosegundos a menos que a luz. Vários outros físicos suspeitaram que o resultado era devido a algum tipo de erro, dado que está em contradição com a teoria da relatividade restrita de Einstein, que diz que nada pode viajar acima da velocidade da luz. Essa teoria foi confirmada por vários outros experimentos feitos em várias décadas.

De acordo com fontes familiares com o experimento, a discrepância de 60 nanosegundos parece vir de uma conexão ruim entre um cabo de fibra óptica que conecta o receptor de GPS usado para corrigir o tempo de vôo dos neutrinos e uma placa de computador. Depois de apertar a conexão e, então, medir o tempo que a luz leva para se propagar na fibra, os pesquisadores encontraram que os dados chegam 60 nanosegundos antes do que foi assumido durante a análise. Já que esse tempo é subtraído do tempo de vôo, parece que também explica a chegada mais cedo dos neutrinos. Novos dados, contudo, serão necessários para confirmar essa hipótese

Agora é esperar para ver, mas acho que conexão solta é muito mais provável de acontecer que violação de simetria de Lorentz. Só dizendo.

Update — Parece que foi confirmado pelo CERN:

http://www.cbc.ca/news/technology/story/2012/02/22/technology-faster-than-light-neutrinos.html

Mais também no Cosmic Variance:

Update 2: E, finalmente, alguém do OPERA falou. A fonte é o blog da Nature:

A colaboração OPERA, dando continuidade à sua campanha de verificações da medida da velocidade do neutrino, identificou dois problemas que podem, de forma significativa, afetar o resultado publicado. O primeiro é ligado ao oscilador usado para produzir o selos-temporais dos eventos entre as sincronizações dos GPS. O segundo problema é relacionado à conexão de uma fibra óptica que traz o sinal do GPS externo para o cronômetro central do OPERA

Higgs no CDF, massa do W e incertezas experimentais

No final da semana passada apareceu um artigo num blog da Scientific American, escrito por Michael Moyer:

Fermilab Set to Reveal “Interesting” Higgs Boson Results

com um rumor de que o CDF vai anunciar uma observação de um bump nos seus dados consistente com um Higgs de massa igual a 125 GeV. Aparentemente a evidência chega aos , o que é muito curioso, já que o CDF sozinho não deveria ser capaz de ter uma evidência tão grande do Higgs.

Também está escrito que eles devem anunciar novas medidas de precisão da massa do quark top e do bóson W no dia 23. A massa dessas 3 partículas são as quantidades com maior poder estatístico de nos dizer quão consistente é o modelo padrão. Eu já expliquei aqui o porquê, mas não custa repetir: Por causa da unificação eletrofraca, a massa do bóson W não é um parâmetro do modelo padrão, mas uma quantidade que pode ser calculada. O resultado do cálculo da massa do W depende fortemente da massa do bóson de Higgs e do quark top e, ao medir muito precisamente essas três grandezas podemos saber se o modelo padrão é consistente ou não.

Numa note mais pessoal, foi meio curioso ouvir sobre o anuncio da nova medida da massa do W no CDF pela SciAm (oops, scooped!). Como que ninguém me contou essa fofoca antes? Mas vamos em frente…

Update: O Fermilab anunciou um seminário Wine and Cheese para o anúnico da nova medida da massa do W pelo CDF no próximo dia 23, às 10hs da manhã (horário do Fermilab, 2pm no Brasil). O video stream da palestra, para quem interessar, pode ser visto aqui.

Semana passada também apareceram dois vídeos interessantes no youtube. Um primeiro falando sobre o que é modelo padrão:

e um outro do Frostbite Theater do JLAB mostrando como medir a velocidade da luz com chocolate:

A propósito, se você não conhece o canal do JLAB no youtube, está perdendo tempo. Todos os episódios do Frostbite Theater são divertidíssimos.

Finalmente, um desafio interessante. Vamos dizer que você está medindo uma certa grandeza física por dois métodos diferentes. Considere que esses dois métodos não são completamente independentes e que possuem uma correlação estimada em . Considere ainda que a incerteza dos dois métodos são

e

com

.

Se os valores medidos são e

, qualquer pessoa suporia que a melhor estimativa

para o valor real da sua grandeza é algo entre

e

. Mais próximo de

, pois sua incerteza é menor.

Ok, o objetivo desse desafio é ver o poder que correlações têm: usando o método dos mínimos quadrados que todo mundo aprender na escola, diga-me se o que eu descrevi no parágrafo acima (da melhor estimativa estar entre os valores medidos) é sempre verdade independente de .

A resposta é que não. Para , a segunda medida não muda em nada o resultado da primeira e, para

, a melhor estimativa do valor real não vai estar entre os dois valores medidos! Você tem uma intuição do porquê isso acontece?

Referências para quem quiser ler como resolve esse problema:

How to combine correlated estimates of a single physical quantity

Combining correlated measurements of several different physical quantities

A massa do W… o meio.

Olá caríssimos,

Se lembram que eu fiz um post há algum tempo atrás com umas das primeiras medidas da massa do bóson W? Para refrescar a memória: A massa do W… o início. Um longo caminho foi percorrido depois daquilo. O buraco que hoje tem o LHC antes tinha o LEP, que era um colisor de elétrons e pósitrons e nele haviam outros quatro experimentos: DELPHI, OPAL, L3 e ALEPH. Todos eles mediram a massa do W, mas não pela massa transversa, como na imagem que copiei no post anterior.

Num colisor elétron-pósitron, você não consegue produzir eventos com apenas um W, porque senão carga elétrica não seria conservada. Para medir a massa do W eles usavam eventos W+W-, ou medindo a dependência da seção de choque com a energia perto do limiar de produção de um par de W, ou realmente medindo a massa invariante em decaimentos totalmente hadrônicos (cada um dos W decaindo para dois jatos) e em decaimentos para lépton + jatos (um W decaindo em dois jatos e o outro para um lépton e um neutrino). Se o colisor de elétron-pósitron tem essa desvantagem de não produzir eventos com apenas um W, eles tem a vantagem de saber (muito) precisamente a energia e o momento total da interação. Isso quer dizer que, tendo apenas um neutrino no decaimento, ainda dá para fazer uma reconstrução cinemática total. No caso em que os dois W decaem para lépton e neutrino, esquece.

Em colisores próton-antipróton, como era o SPS e como era ;( o Tevatron, não dá para reconstruir o momento longitudinal do neutrino porque, no fundo, o que você está colidindo são quarks e glúons e a fração de momento do (anti)próton que eles carregam não é sempre a mesma, varia de colisão para colisão e é impossível de se saber. No Tevatron, “a melhor maneira” (mais sobre isso num post posterior) de se medir a massa do W é justamente como mostrado no post anterior: medindo a distribuição de massa transversa.

Eu queria mostrar para vocês o que foi feito no Tevatron até hoje. Mas em vez de ficar escrevendo um texto infinito, resolvi fazer algo diferente. Eu não sou muito bom com gráficos, mas fiz uma tentativa frustrada de infografo relembrando todas as medidas da massa do bóson W feitas pelo D0 e pelo CDF até hoje. A imagem está depois do fold.

Boicote a Elsevier, Higgs e Moriond

Olá, abandonados leitores. Aparentemente ninguém mais escreve nesse blog. Ou estamos fazendo artigo que vai ganhar o prêmio Nobel ou ficamos todos preguiçosos. Espero que seja um Nobel, mas duvido.

Nesse início de ano, um dos assuntos mais quentes na blogesfera científica tem sido o boicote à editora Elsevier. Ele foi iniciado pelo matemático Tim Gowers e posteriormente refinado numa declaração mais detalhada com 34 iminentes matemáticos como signatários, entre eles alguns famosos na internet como o Terence Tao (mais aqui) e o John Baez. O único brasileiro signatário dessa lista é o matemático do IMPA Artur Ávila. Blogueiros de outras áreas também se manifestaram, como o físico Adam Falkowsi e o biólogo Michael Eisen, esse último com um grande histórico na luta pelo Open Access (mais sobre ele abaixo). No Brasil, eu vi o blog do Atila Iamarino comentando sobre o assunto. O movimento resultou na criação de um abaixo assinado The cost of knowledge, onde cientistas do mundo inteiro estão se comprometendo a não publicar, não revistar e não editar artigos para jornais da Elsevier.

Esse boicote também teve bastante repercussão na imprensa formal, com colunas no The Chronicle, na The Economist, no The Guardian, na Forbes, na Nature, na Revista Piauí e em outros mais tanto que eu não tive saco de procurar. Uma lista completa da repercursão dessa história pode ser encontrada nessa página do projeto PolyMath.

Chega de referências e vamos explicar o que está acontecendo.

Como é feita a divulgação da ciência

Para muitos dos leitores, essa seção não vai ter nenhuma novidade. Mas eu acho que é importante contar para quem não sabe como funciona a dinâmica de trabalho na ciência. Um cientista faz um trabalho e escreve um artigo com o resultado da sua descoberta. Para validar seu trabalho frente à comunidade científica, ele manda esse artigo para o processo de peer review (revisão por pares), em que outros cientistas especialistas da área revisam o artigo e avaliam sua qualidade. Os artigos julgados bons são então publicados em revistas.

Bem, essa é a idéia. Na prática acontece assim: você tem um artigo pronto e manda para a revista onde você quer publicar. O artigo vai para mão do editor que avalia a adequação do assunto para a revista. Mas vocês acham que a revista paga para esse editor? Não, as revistas pedem que cientistas sejam editores e não pagam nada! Ou seja, parte da atividade que está sendo paga no salário do cientista passa a ser editar artigos para uma revista que não tem nada a ver com sua instituição de pesquisa.

Estando no escopo da revista, o editor vai mandar o artigo para um revisor. Novamente, vocês acham que a revista contrata os cientistas para revisar artigos, certo? Errado de novo! Os editores pedem que cientistas façam esse trabalho de revisão e não pagam nada! Quem paga esse trabalho é o instituto de pesquisa que está pagando o salário dos cientistas.

Estando o artigo aprovado, ele é publicado em revistas impressas e online. Mas, claro, essas revistas são pagas e nem o cientista que escreveu, nem o que revisou, nem o que editou tem direito a ter esse artigo a não ser que pague. E pague bem. Pague para quem? Para a editora, claro! O mesmo vale para todas as bibliotecas que compram a revista impressa ou o acesso online. O mesmo vale para a CAPES no Brasil, que paga mais de 133 milhões de reais por ano para essas editoras.

É um grande esquema, certo? As editoras não tem trabalho de escrever, não tem trabalho de editar, não tem trabalho de revisar, mas o lucro é todo delas.

Assumindo que cientistas não são idiotas, a pergunta natural é: quem deixou isso começar? e porque isso continua assim? Isso começou numa época onde o trabalho das editoras era importante, porque ninguém tinha um computador pessoal para digitar trabalhos e ninguém tinha internet para acessar os artigos. Então, as editoras tinham o importante papel de divulgar o trabalho dos cientistas. Hoje, com a internet, isso está longe de ser verdade.

O porquê de continuar assim é outra história. É inegável que o processo de peer review seja importante. E as pessoas só acreditam nesse processo se ele for feito pelas editoras das revistas (veja o que o Tim Gowers tem a dizer sobre isso). Além disso, essas revistas ganharam prestígio e o prestígio começou a ser medido com números chamados fatores de impacto e os fatores de impacto das revistas em que os artigos foram publicados são usados para determinar quem consegue emprego aonde e quem consegue financiamento para seu próximo projeto.

Não é verdade que essas sejam necessidades irreversíveis, mas para mudar o status quo dá trabalho e exige um esforço ativo das pessoas que desejam contra aquelas que desejam manter a situação como está. E as editoras querem! O lucro da Elsevier em 2010 foi de 2 bilhões de reais! Outras editoras científicas famosas como a Springer ou a Wiley não ficam muito atrás.

Editoras alternativas e alternativas Open Access

Certo, a gente não gosta dessas editoras malvadas. Mas qual é a opção? A opção menos traumática é usar editoras associadas às universidades, associações de classe e institutos de pesquisa. Um exemplo disso em física são as Physical Reviews, que são publicadas pela American Physics Society (o equivalente da SBF aqui nos EUA). A Physical Review Letters, por exemplo, tem um fator de impacto altíssimo e é a revista de física mais prestigiada para letters hoje em dia.

Essas revistas não são mais baratas que as revistas da Elsevier. Por exemplo, duas revistas bem comparáveis da APS e da Elsevier são a Physical Review D e a Nuclear Physics B, respectivamente. As duas são revistas especializadas em física de altas energias que publicam artigos completos, não somente letters, como é o caso da PRL. Uma assinatura institucional da PRD fica entre 3000 e 7000 dólares por ano, dependendo do tamanho da instituição. A assinatura da NPB fica em torno de 5000 dólares por ano. Ou seja, não é essa a diferença. A diferença é que há esse sentimento de que o dinheiro retornaria para uma instituição com fins científicos ou de suporte aos cientistas.

A opção mais drástica, mas para muitos a mais correta, é perceber que não há mais necessidade de editoras para o processo de revisão e divulgação dos resultados científicos. No que diz respeito à divulgação, isso é bem óbvio. O maior exemplo disso é o arXiv. Eu, honestamente, não me lembro a última vez em que li um artigo recente que não estivesse no arXiv. Mas, ao mesmo tempo, eu sei que a área de física de altas energias é privilegiada nesse aspecto. Mesmo em física há áreas em que nem todos os artigos são disponibilizados como preprints.

Em outras áreas de pesquisa, a situação é diferente. Biologia é um caso interessante. Eles não tem um servidor de preprint tão universal quando o arXiv, embora haja idéias se criar um como o The Faculty of 1000. O que eles têm já em funcionamento são iniciativas open access, como a PLoS, em que o ônus da publicação é revertido ao autor, no lugar do leitor (dois comentários para ser completo: a Elsevier também tem esse tipo de publicação, mas com pormenores, e esse tipo de revista também existe em física, por exemplo, o PRX). Além disso, há uma lei muito interessante aqui nos EUA: toda pesquisa financiada pelo NIH (o equivalente do CNPq para as pesquisas em biocoisas aqui nos EUA) tem, por obrigação legal, que ser disponibilizada em open access até um ano depois da sua publicação.

Essa obrigatoriedade é muito interessante. Não só pelo aspecto social de que uma pesquisa financiada pelo povo deve ser acessível livremente, mas também porque torna acessível aos próprios cientistas que não estão ligados a instituições de pesquisas e que não podem pagar pela assinatura. Há inclusive um projeto de lei, o Federal Research Public Access Act, nas duas casas para estender essa lei a qualquer agência de financiamento pública de pesquisa científica. Você pode ler detalhes no blog do Baez e do Eisen. Isso incluiria todas as pesquisas em física financiadas pela NSF e pelo DOE, que na prática são quase todas.

Ou seja, eu acho que óbvio que, com a internet, divulgação de resultados não é um problema. Há opções open access, servidores de preprint ou, se você não quiser nada disso, cria uma página com links para seus artigos. A questão de revisão é mais complicada. Os cientistas não trabalham “de graça” para as revistas porque são ingênuos (alguns discordariam!), mas justamente por causa do prestígio envolvido na publicação em uma revista de grande nome. Artigos publicados em revistas como a Nature ou a Science têm muito peso na carreira de um cientista. E é verdade que, no fundo, não deveria. O Eisen, novamente, argumenta muito bem sobre essa falácia. Mas a realidade é que, na prática, têm. Comitês de seleção usam o fator de impacto das revistas para classificar candidatos. Agências de fomento avaliam sua pesquisa baseado no fator de impacto da revista em que o resultado foi publicado. Nem sempre a avaliação é numerológica, pois, quando é, distorções assustadoras acontecem, mas sempre o peso do nome da revista tem uma influência tão grande quanto a qualidade científica do material publicado.

Triste, mas verdade.

E a Elsevier, o que tem a ver com isso tudo? E o Higgs?

Como eu disse, a Elsevier não é a única malvada da história. Mas algumas atitudes enfureceram as pessoas a ponto de tornar esse boicote público, em vez de pessoal. Dentre os pontos mais citados estão os preços exorbitantes; a prática de bundling, que é a venda associada de assinatura de boas revistas com revistas ruins; e o lobby para a Research Works Act, que é uma proposta de lei diametralmente oposta a FRPAA, que propõe que nenhuma pesquisa financiada publicamente possa ser divulgada por canais Open Access. Não acho que outras editoras, como a Springer, façam as coisas de forma muito diferente. Mas ela tem um histórico junto à comunidade de matemática que a fez merecer um desconto, pelo menos por enquanto.

Também não é claro que esse boicote vá afetar de alguma forma a Elsevier. O abaixo assinado, até hoje, tem por volta de 5000 assinaturas, em grande parte de matemáticos. Os jornais mais famosos da Elsevier não são de matemática. Eu acho que são o Cell e o The Lancet, na área de biologia. No todo, a Elsevier tem 2000 jornais e recebe artigo de mais de 600 mil cientistas! 5000 é realmente muito pouco, mas é um começo. Um começo que foi notado. As ações da Elsevier deram uma caída no mercado e eles se preocuparam a dar uma resposta sobre as acusações. O conteúdo da resposta é cheio de frases duvidosas, de sentido amplo demais para serem realmente válidos. Do tipo “Nós trabalhamos com os cientistas e é duro ser criticado por eles.”: esse “com” pode ser entendido de várias formas e em muitas delas isso não é verdade. Uma crítica be estruturada foi feita pelo Stephen Curry.

Na contramão desse movimento, o Atlas e o CMS mandaram aquele bonito resultado sobre o Higgs do final do ano passado para uma revista da Elsevier, a Physics Letters B (veja na parte de Comments do link para o arXiv). Eu não faço a menor idéia se isso tem alguma coisa a ver com toda essa história de boicote, mas é muito estranho que esse resultado tão importante seja publicado numa revista tão sem expressão. Os resultados ainda não foram combinados, mas foram refinados em comparação ao apresentado no fim do ano passado e sobre o qual eu falei aqui no blog. O CMS, mostrando ser muito mais eficiente em analisar seus dados que o Atlas, ainda adicionou mais um canal: o de dois fótons com dois jatos frontais. Essa é uma típica assinatura de quando o Higgs é produzido por fusão de W ou Z, pois esses jatos são o que carrega a carga de cor do quark ou glúon que colidiu. Essa não é uma análise simples, pois a região frontal é muito suja por causa dos remanescentes do próton. Além disso, esse é um sinal muito mais fraco que o modo de produção por fusão de glúons e não é claro que nenhum dos dois experimentos teria qualquer possibilidade de ver eventos com a luminosidade integrada disponível. Mas, apesar disso tudo, o CMS achou alguns eventos e a evidência do Higgs ficou mais forte ainda. Só o fato desse modo de produção ser raro e ainda assim já estarmos vendo sinal foi interpretado por alguns como uma evidência de que a taxa produção do Higgs é incompatível com a previsão do modelo padrão. Ainda é muito cedo para dizer qualquer coisa, mas você pode ler mais detalhes no blog Résonaances.

O Atlas, que ainda é muito mais lento do que o CMS para fazer análises, não adicionou nenhum canal e continua apenas mostrando o mesmo resultado do ano passado. É provável que novidades, inclusive uma combinação Atlas+CMS pela procura do Higgs (!!!), serão anunciadas na conferência de Moriond desse ano. Essa é a primeira grande conferência de altas energias do ano e tanto os experimentos do LHC quanto do Tevatron estão guardando grandes surpresas. Eu vou estar lá apresentando meu trabalho e, se possível, contando para vocês as novidades assim que elas saírem.

Retrospectiva 2011

Dois mil e onze foi um ano notável para física de altas energias. Eu, na minha curta vida, não me lembro de um ano tão excitante quanto esse. A quantidade de fofocas e resultados foram tão grandes que não passavam duas semanas sem um assunto interessante sendo discutido nos corredores dos departamentos de física ao redor do mundo.

Vamos então fazer uma breve retrospectiva do que aconteceu.

Janeiro: O ano começou com a triste, ainda que cientificamente correta, decisão de terminar as operações do Tevatron no final do ano fiscal. Nesse mês, o Tevatron teve seu limite de produção de Higgs duramente atacado num artigo téorico escrito por Baglio, Djouadi e cia. Depois de muito bate boca, ficou claro que o “erro” que o Tevatron teria cometido não existe e que os autores usaram distribuições de pártons inedequadas. Ainda em janeiro, o CDF publicou um resultado que mostrava uma grande assimetria forward-backward na produção de . Essa assimetria foi posteriormente confirmada no D0 e por novas medidas do CDF. Embora o LHC não possa medi-la diretamente, outras medidas sensíveis a efeitos que causariam a assimetria do Tevatron foram feitas pelo CMS, pelo ATLAS e nada foi encontrado. Um paper que não chamou tanta atenção, mas merece ser citado, foi a primeira medida do fluxo de carga de cor feita pelo D0.

No Ars Physica:

Fevereiro: O LHCb começou o mês com a primeira observação do decaimento (um decaimento importante pois o estado final é um autoestado de CP e pode-se fazer uma medida da fase de violação de CP sem uso de análise angular) e depois confirmado pelo D0 e CDF. Esse tipo de análise foi feita, também pela primeira vez pelo LHCb, agora em dezembro. Ainda em fevereiro, ficou decidido que o LHC rodaria em 2011 e 2012 a

. A previsão feita então para a luminosidade integrada durante este ano que passou foi de

entregue a cada um dos grandes experimentos. Terminou com mais de 5 vezes essa quantidade!

No Ars Physica:

Março: O primeiro de muitos resultados estranhos no ano. O CDF reportou uma diferença na massa do quark top para o anti-quark top de e interpretou isso como uma possível assinatura de um efeito que violasse CPT. Outros experimentos, primeiramente o D0 e posteriormente CMS, mediram a mesma diferença e não confirmaram o resultado do CDF.

Abril: O CDF publica um excesso de eventos na distribuição de massa de di-jatos produzidos em associação com um bóson W. Eles interpretaram esse excesso como uma possível nova partícula com massa em torno de e gigantesca seção de choque. O mesmo bump foi procurado pelo D0 e pelo ATLAS posteriormente e nada foi encontrado. Nesse mesmo mês o LHC começou a operar com uma luminosidade instantânea maior que a do Tevatron. Ainda em abril, uma nota interna do ATLAS vazou com uma possível ressonância em torno de

observada no canal de di-fótons. O resultado foi refutado pela própria colaboração ATLAS posteriormente. Para fechar esse mês em que ninguém dormiu, o XENON100 publicou seu primeiro resultado excluindo a área em que o DAMA havia interpretado como possível de se encontrar matéria escura devido a uma modulação do sinal detectado por esse experimento.

No Ars Physica:

Maio: Outro experimento de matéria escura, o CoGeNT também detecta uma modulação anual no seu sinal, consistente com a do DAMA em fase e criando mais tensão na interpretação com o resultado do XENON100. Ainda em maio, o FERMI confirmou o excesso de pósitrons de altas energias detectado pelo PAMELA no ano anterior. Alguns viram esse excesso como um sinal de matéria escura, mas outras soluções mais comuns também foram propostas. Para terminar esse mês “espacial”, o AMS entrou em operação, mas até onde eu sei, nenhum resultado foi apresentado até o final desse ano.

No Ars Physica: